Киберсигурност в ерата на дълбоките фалшификати

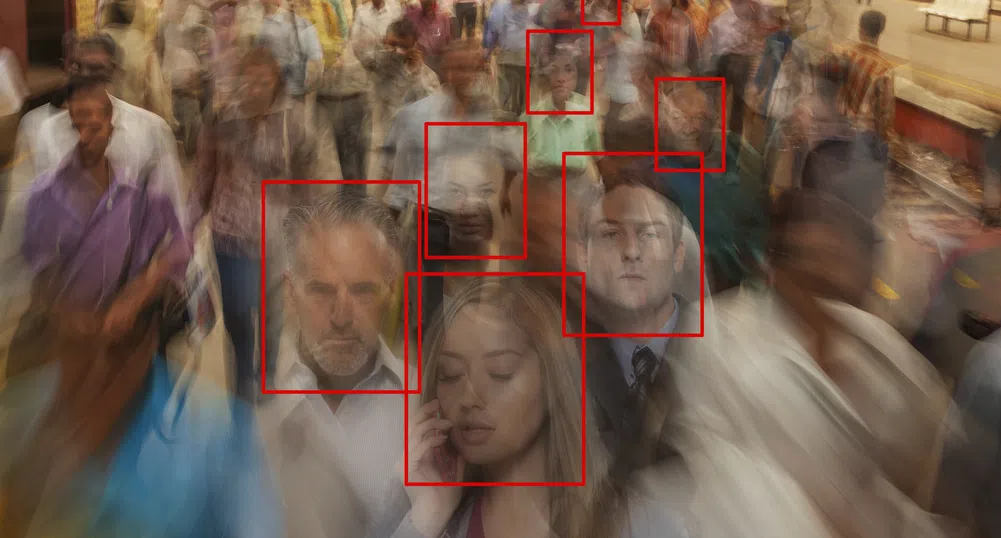

AI прави атаките чрез цифрово инжектиране и фалшива самоличност все по-високо технологични

AI прави атаките чрез цифрово инжектиране и фалшива самоличност все по-високо технологични

Професионалистите в областта на киберсигурността и управлението на риска имат много проблеми, които не им позволяват да спят нощем. Ерата на дълбоките фалшификати (deepfake) с изкуствен интелект е тук и за съжаление днешните методи за подсигуряване и проверка на самоличността няма да оцелеят още дълго. Gartner изчислява, че до 2026 г. почти една трета от предприятията ще считат решенията за проверка на самоличността и удостоверяване на автентичността за ненадеждни заради генерираните от AI дълбоки фалшификати.

От всички заплахи, с които се сблъскват ИТ организациите, атаката с инжектиране, която използва генерирани от AI дълбоки фалшификати, е най-опасната. Неотдавнашни статистики показват, че подобни атаки са способни да заобиколят лесно популярни защитни системи от типа “Know yоur Customer” (KYC). Анализаторите в сектора отчитат 200% увеличение на атаките чрез инжектиране през миналата година, което принуждава ИТ директорите и бизнес ръководителите да разработват стратегии за тяхното отблъскване, особено когато те са базирани на дълбоки фалшификати.

На първо място, ръководителите трябва да разберат как точно зловредните актьори използват AI дълбоките фалшификати, за да атакуват техните системи. Чак след това те могат да разработят подходящи стратегии, които да подпомогнат не само за откриването им, но и за тяхното отразяване.

Специализираното издание CIO дава няколко насоки в това отношение.

Атака чрез цифрова инжекция

Атаката с цифрово инжектиране обхваща случаите, в които някой „инжектира“ фалшиви данни, включително документи, снимки и биометрични изображения, генерирани от AI, в потока от информация, получаван от платформата за проверка на самоличността (IDV). Зловредните актьори използват виртуални камери, емулатори и други инструменти, за да заобиколят камерите, микрофоните или сензорите за пръстови отпечатъци и да заблудят системите, че са получили истински данни.

Подобни кампании сега са пет пъти по-често срещани от други типове широко разпространени атаки, а когато се използват в комбинация с генерирани от изкуствен интелект дълбоки фалшификати, е почти невъзможно да бъдат открити. Нападателите използват подправените документи за самоличност, за да заблудят процесите на KYC системите, или инжектират дълбоко подправени снимки и видеоклипове, за да заблудят системите за лицева биометрия. Ярък пример за това е неотдавнашна атака, при която е използван дълбок фалшификат, генериран от AI, за да се измами компания от Хонконг за 25 млн. долара.

Както се очакваше, с възхода на генеративния AI, дълбоките фалшификати също се увеличиха, като Onfido отчита 3000% ръст през миналата година. Това принуди Агенцията за национална сигурност на САЩ, ФБР и CISA да излязат със съвместно предупреждение, че „нарастващата наличност и ефективност на техниките на синтетичните медии, достъпни за по-малко способни зловредни актьори, показват, че високотехнологичните кампании ще растат както от гледна точка на честота, така и като сложност“.

Ключът към спирането на атаките с инжекции е да се предотврати изобщо въвеждането на цифрово променени изображения или документи. А единственият начин да се постигне това е да се използват усъвършенствани технологии за сигурност, като например мобилна криптография.

Криптографските подписи, осигурявани от мобилните устройства, операционните системи и приложенията, са практически невъзможни за фалшифициране, тъй като са подкрепени от изключително високите нива на сигурност на Apple и Android. Използването на мобилната криптография за определяне на автентичността на устройството, неговата операционна система и приложението, което се използва, е ключова и решителна мярка за спиране на атаките с инжектиране още в зародиш.

Атаки чрез фалшиво представяне

Атаките чрез фалшиво представяне включват използването на неистински данни, които заблуждават сензорите или скенерите за документи, че пред тях стои оторизиран за достъп краен потребител. Атаките чрез фалшиво представяне на лицеви биометрични данни приемат много форми, като използват генерирани от AI фалшиви документи за самоличност, модели за „подмяна на лица“ и дори хиперреалистични маски. IDV и KYC платформите използват специализирани системи, за да предотвратяват подобен тип атаки, но много от тях могат да бъдат преодолени чрез инжектиране, базирано на дълбоки фалшификати, генерирани от AI.

Превантивни мерки срещу атаките

През последните няколко години хиляди компании станаха жертва на този тип атаки. Въздействията им са неизчислими - кражби на стотици милиони долари, прекъсвания в работните процеси, които засягат милиони хора, открадната лична информация и непоправимо увредена репутация. И проблемът само се задълбочава.

Единствената стратегия за спиране на подобни кампании е да се използват инструменти за проверка на самоличността, които първо предотвратяват атаките с инжектиране, а след това се фокусират върху сигурна проверка на действителния човек, който стои пред екрана от другата страна. По този начин ИТ организациите могат да затворят и човешките вектори за социално инженерство, които заобикалят или използват процесите на IDV.

Освен това чрез добавяне на технологии за проверка чрез интелигентни устройства, модели с изкуствен интелект и поведенчески биометрични данни ИТ организациите могат допълнително да намалят риска от измами.

И накрая, инвестирайте в решения, които защитават процесите на многофакторно удостоверяване (MFA) и възстановяване на пароли, тъй като това е ключова уязвимост, която компаниите често пренебрегват, съветват експертите пред CIO.

)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)